인공지능 제 5(종)강

인공지능은 지능을 키우는 기계학습으로 일하는 방법을 배우고 익혀서, 인간이 명령하는 Task를 수행하는 인간이 만든 기계 지능입니다.

인간의 지능은 두뇌에 깃들어 있습니다. 태어날 때부터 가지고 온 천부적 지능과 학습을 통한 후천적 노력형 지능의 융합으로 인간은 많은 일을 합니다.

인공지능이 학습하는 기계는 머신러닝(기계학습)이라는 컴퓨터 모델이고, AI 작동의 힘은 이 모델을 돌리는 알고리즘(Task 처리 기법)입니다.

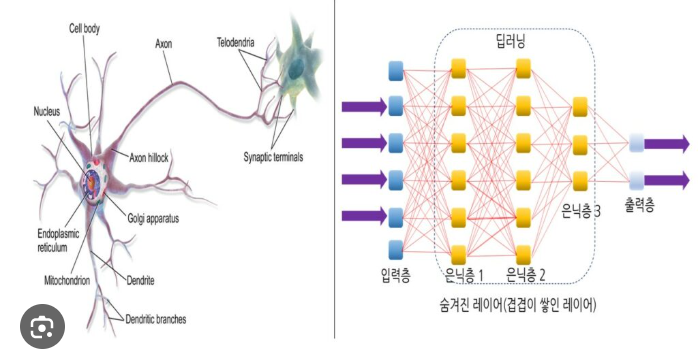

인간 지능은 두뇌 속 신경망에 흐르는 정보 활용입니다. 그 활용은 지정 의(知情意)입니다. 두뇌 신경망은 입력 수상돌기로 정보를 받아들입니다. 그 정보를 신경세포 핵에서 처리합니다. 그 처리 내용의 수준이 정해진 문턱치에 도달하면 그 정보를 축삭으로 보냅니다. 축삭은 이웃 신경망과 시냅스라는 연결 신경 길음 만들어, 이를 통해서 그 받은 정보를 출력 정보로서 이웃 신경의 수상돌기로 내보냅니다.

이런 정보흐름이 다양해져서(지성, 감성, 의지) 지능을 이루는 것입니다. 신경망 내 정보는 아주 약한 전기를 통하여 흐르고, 시냅스 속의 정보는 특정 화합물을 통하여 흐릅니다.

우리 몸속에는 신경망을 통하여 미세한 전기가 흐르고, 다양한 물질의 원자도 존재합니다.

그 원자의 종류는 흙의 그것과 같다고 합니다. 사후에 흙으로 돌아가는 이유를 알 것도 같습니다.

머신러닝 모델은 입력 측, 은닉층과 출력층으로 구성하고, 이 모델로 학습을 하여, 그 학습한 내용으로 Task를 처리합니다. 입력 층고 은닉층을 늘려서 학습의 내용도 다양하게 합니다. 그 학습방법은 지도학습, 비지도 학습과 강화 학습이 있습니다.

지도학습은 예를 들어 설명하면 이해가 쉽습니다.

기계학습 모델에게 고양이를 인식하는 법을 학습시킵니다. 고양이 머리 모습을 다양하게 입력하여 인식시킵니다. AI에게 고양이라는 라벨(이름)과 함께 수많은 머리 그림을 학습시킨 후, 고양이 머리 사진을 입력하면 고양이라는 출력을 내보냅니다. 고양이 인식의 인공지능이 형성된 것입니다. 이런 실력을 인식기반 인공지능이라고 합니다

이번에는 비지도학습을 살펴봅니다.

고양이 모습과 개 모습을 각각 입력하여 학습을 시킵니다. 그러면 개와 고양이 모습을 그룹화하여 구분하는 인공지능이 만들어집니다. 고양이와 개를 섞은 라벨 없는 그림을 입력하면, 그 두 가지를 군집화시켜서 구분해 출력합니다. 물건을 군집화하여 구분하는 인공지능이 형성된 것입니다.

이 경우 학습을 처리하는 계층인 은닉층이 하나이면 머신러닝(Machine Learning)이라고 하고, 다수이면 딥러닝(Deep Learning)이라고 합니다. 기계학습은 큰 범주이고 딥러닝은 그 범주 속 핵심적인 기법입니다.

머신러닝의 경우 물건 모습이 아니고 출력 답에 대한 보상을 걸어주어 학습을 시키는 방법을 강화 학습(Renforcement Learning)이라고 합니다. 일기예보와 주식시세 분석은 강화 학습을 활용합니다. 머신러닝의 입력 데이터를 처리하여 출력 데이터로 내보내는 과정은 쉽지가 않습니다. 정답과 학습 데이터를 사용하여 기계학습을 시켰다고 하더라도 단 한 번에 그 정답을 맞혀 낼 수는 없습니다. 정답과 출력값(근삿값으로 나옴)의 차이 즉, 오차를 여러 번 학습으로 줄여 나가면 종국적으로 정답에 가깝게 됩니다. 이런 학습방법을 경사하강법이라고 합니다.

딥러닝 과정을 수학적 대수 모델(불 대수)로 나타내려면 2차 함수가 가장 적합하고, 이를 그래프로 그리면 XY 직교좌표를 가진 원점에 대칭인 그래프가 됩니다. 원점에 가까워질수록 정답으로 수렴하는 것입니다. 그 과정이 마치 그 그래프 곡선을 따라서 출력 데이터가 내려가는 형국이라 경사하강법이라고 명명한 것입니다. 딥러닝의 정답을 찾아내는 기법에는 오차 역전파 기법도 동시에 적용합니다.

입력 데이터는 정답에 미치는 영향을 따져서 각각의 해당 입력값을 산정해 줍니다. 은닉층의 영향도 가중치라는 값을 주고, 입력값과 가중치 합인 출력 데이터와 정답의 차이 즉, 오차를 따져 나갑니다.

이 경우 출력층에서 은닉층과 입력 측으로 되돌아가면서 오차의 크기를 줄여 나갑니다.

그 결과를 보아 아직도 정답이 만족스럽지 못하면, 또다시 이 과정을 왔다 갔다 반복하면서 최종적으로 만족스러운 정답을 구해내는 것입니다.

[입력층> 은닉층> 출력층] 방향을 순정파라 하고, [출력층> 은닉층> 입력층] 방향을 역전파라고 합니다. 이렇게 역전파 방향으로 오차를 줄여나가는 방법을 오차 역전파 기법(알고리즘)이라고 합니다.

입력 측, 은닉층, 출력층, 입력값, 가중치, 정답과 오차, 경사하강법, 오차 역전파 기법 등으로 머신러닝, 딥러닝, 지도학습, 비지도 학습, 강화 학습 등의 절차와 방법(Algorithm)으로 인공지능 모델의 지능을 형성시키는 것입니다.

이제 인공적인 지능이 지적 능력을 갖춰서 Task를 수행해 내는 모델을 살펴봅니다.

대표적인 인공지능 모델은 챗 지피티(Chat GPT) 입니다. GPT는 Generative Pre-trained Transformer의 약자라서 생성형 모델이라고 합니다. 이 대화 생성형 모델은 인간과 자연어로 대화가 가능합니다.

대화 생성형 모델의 딥러닝 방법을 설명합니다. 이 모델의 원천기술은 LLM(Large Language Model)입니다. 이 LLM(대형 언어 모델)에게 입력 데이터 수십억~수 조 문장을 데이터로 사용하여 딥러닝 시킵니다. 그 학습 방법은 그 문장 속 단어와 단어의 관계를 학습합니다. 그리하여 그 관계를 확률통계로 정리하며 학습하고, 그 결과를 메모리에 저장하여 기억합니다.

새로운 Task의 문장 속 단어는 이 모델의 메모리에서 가장 높은 확률 값에 해당하는 것으로 선정하여(명사와 형용사의 관계, 부사와 형용사의 관계 등) 대화하고자 하는 문장에 적용합니다. 소동파의 문장처럼 격조가 높은 글도 지어내고, 이태백의 감흥을 지닌 명시도 척척 지어냅니다. 요즘은 AI가 지은 글인지 인간의 고유한 실력으로 지은 글인지를 구분하는 문제가 새로운 과제로 대두되었습니다.

AI의 딥러닝 같은 학습은 인간의 두뇌회전 속도와 기억력으로는 도저히 불가능한 것입니다. 그러나 AI 모델은 빛의 속도와 앞의 강의에서 설명한 반도체 디지털 논리회로의 정확성으로, 이런 가공할 능력을 발휘하는 것입니다.

LLM은 진화를 하여 LMM과 LAM 모델이 출시되고 있습니다.

LMM은 Large Multimodal Model로서 문자, 음성, 그림과 동영상을 대답해 냅니다.

LAM은 Large Action Model로서 행동을 나타내는 로봇 모델 입니다. LLM의 학습 데이터 규모를 줄인 SLM(Small Language Model)도 나옵니다.

인공지능 모델은 LLM 이외에도 컴퓨터 Vision 모델, 지식 기반 시스템, CNN, RNN, GNN, 지능형 로봇, 인공지능 비서와 자율주행 자동차 등이 있습니다.

이 모델들의 설명은 생략합니다.

챗 지피티 모델만 잘 활용하면 나머지 모델의 성능은 미루어 짐작할 수 있습니다. 앞으로 현행 모델들보다 더 다양한 인공지능 활용 모델이 창안될 것입니다.

이상으로 인공지능 강의를 마칩니다.

좀 쉬었다가 양자컴퓨터 강의를 해드리도록 하겠습니다.